vllm-omni & DiT Inference Accelerate

导言

vllm专门为了多模态单独推出了推理框架vllm-omni,调研一下

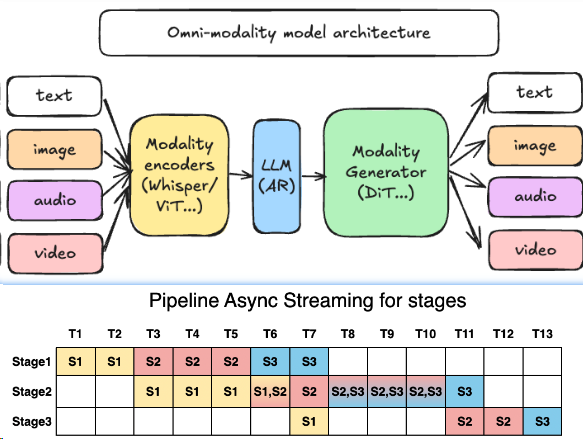

vLLM-Omni 是一个面向全模态(Omni-modality)模型推理与服务的框架,旨在为用户提供 简单、快速、低成本 的多模态模型部署方案。它扩展了原生 vLLM 对文本生成的支持,覆盖 文本、图像、视频、音频 等多模态数据处理,并支持 DiT 等非自回归架构,实现 异构输出(如多模态内容生成)。

核心设计¶

解耦式流水线:分阶段动态分配资源,实现高吞吐与低延迟:4

- 模态编码器(Modality Encoders):负责高效地把多模态输入编码成向量或中间表示,例如 ViT 视觉编码器、Whisper 等语音编码器。

- LLM 核心(LLM Core):基于 vLLM 的自回归文本 / 隐藏状态生成部分,可以是一个或多个语言模型,用于思考、规划和多轮对话。

- 模态生成器(Modality Generators):用于生成图片、音频或视频的解码头,例如 DiT 等扩散模型。

这些组件并不是简单串联,而是通过 vLLM-Omni 的管线调度在不同 GPU / 节点间协同工作。对于工程团队来说,这意味着:

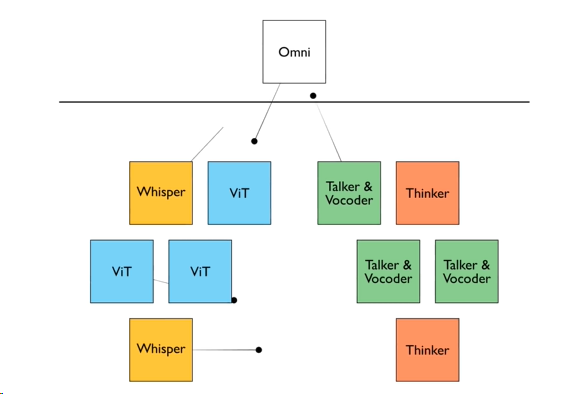

- 可以针对不同阶段单独做扩缩容和部署拓扑设计;

- 可以根据业务瓶颈(如图像生成 vs 文本推理)调整资源分配;

- 可以在不破坏整体架构的前提下替换局部组件(例如切换为新的视觉编码器)。

核心优势¶

- 高性能4

- 继承 vLLM 的高效 KV 缓存管理,优化自回归任务性能

- 通过流水线阶段执行重叠提升吞吐量

- 基于 OmniConnector 的动态资源分配与解耦架构

- 易用性与灵活性

- 异构流水线抽象管理复杂模型工作流

- 无缝集成 Hugging Face 模型库

- 支持分布式推理(张量/流水线/数据/专家并行)

- 提供流式输出与 OpenAI 兼容 API

vllm-omni 相对于 vllm 的必要性/优势¶

- 设计思路:

- 功能上:

- 多模态生成,全模态Omni模型(多模态理解还是走vllm)

- 性能:

- 更细粒度的解耦架构流水线

- 生成加速特性会优先对接社区已有加速库,vllm-Omni做好接口层抽象,CacheDit、sageattn、fastvideo、MindIE-SD已有PR

性能收益¶

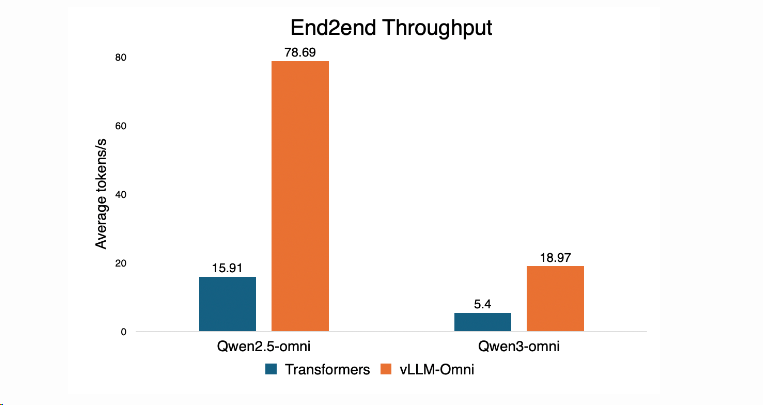

相对于transformers推理有 3.5x ~ 4.9x的提升。4

业界DiT加速特性/案例¶

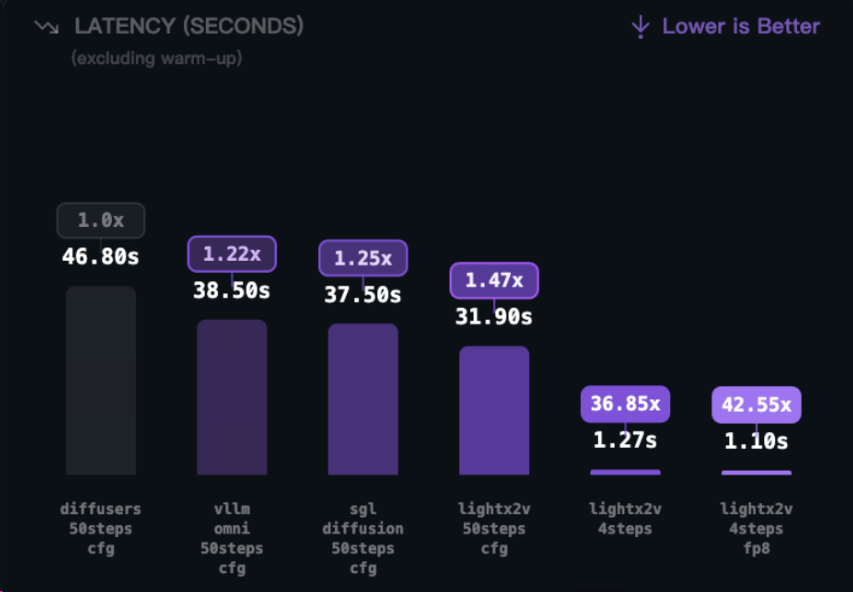

- TurboDiffusion 清华系DeepSeek时刻来了,硅谷沸腾!单卡200倍加速,视频进入秒级时代

- SageAttention

- Sparse-Linear Attention(SLA)

- rCM步数蒸馏加速:更少步生成

- W8A8 INT8量化:线性层加速

- LightX2V Day-0支持Qwen-Image-Edit-2511模型,加速超42倍!

可见还是蒸馏的提升最大:

扩散缓存加速:TeaCache 与 Cache-DiT¶

Cache-Dit 是唯品会开源的一个 PyTorch 原生的 DiT 推理加速引擎(HTTPS://GitHub.com/vipshop/cache-dit),它通过混合缓存加速和并行化技术来加速 DiT 模型的推理。

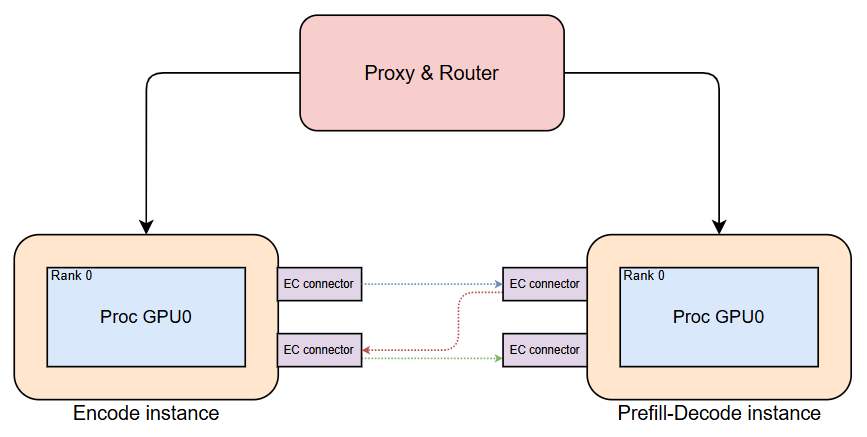

Encoder 分离¶

- 主要好处(个人观点):Encoder 输出设计缓存加速,

6

6 - 最终实现:10%性能提升(吞吐和延迟)

- 注意:1. 在线时使能; 2. Encoder要单独设置占卡:例如实验 1 Encoder + 3 PD instances (1E3PD)

ViT(DP)+LLM(TP)¶

DiT 投机¶

ASDSV (Approximate Speculative Diffusion with Speculative Verification)

MindIE SD¶

支持模型¶

文档说明链接 和 supported_model

- Omni-modality models (e.g. Qwen2.5-Omni, Qwen3-Omni)

- Multi-modality generation models (e.g. Qwen-Image)

后续规划

架构设计¶

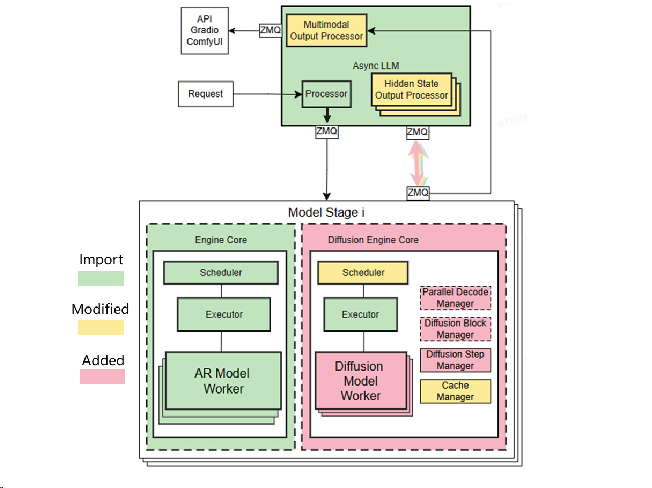

Vllm-omni将从现有的vLLM框架中导入核心模块(LLM),并引入几个新的组件(DiT)和修改(调度器)以实现其目标。核心架构将基于模块化设计,允许独立开发和集成不同的模态处理程序和输出生成器。

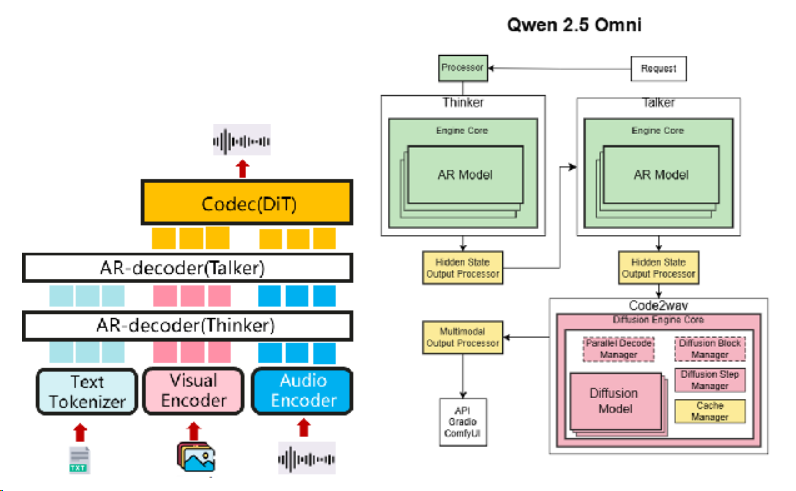

Qwen-omni¶

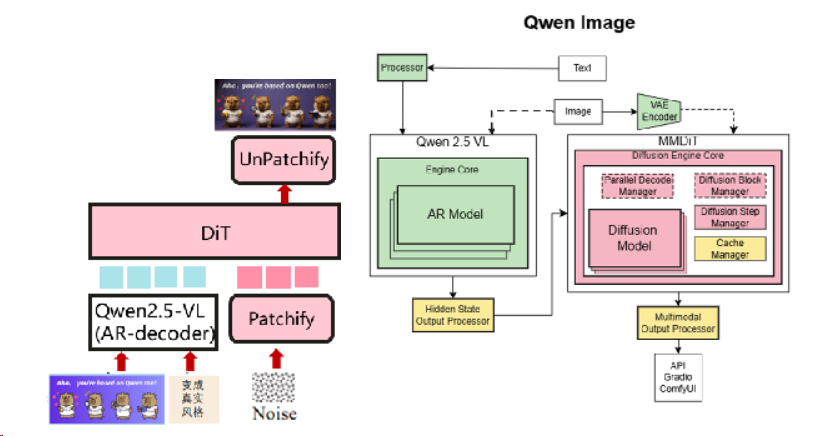

Qwen-Image¶

RoadMap¶

规划模型¶

模型靠社区力量,社区补全能力。

配套支持¶

NPU¶

文档是说是能原生支持的3, 但是上手实测还是跑不通,issue

VeRL+vllm omni¶

社区支持中 issue

代码走读¶

以qwenImage为例子 vllm-omni\examples\offline_inference\qwen_image\text_to_image.py

from vllm_omni.entrypoints.omni import Omni

omni = Omni(

model=args.model,

vae_use_slicing=vae_use_slicing,

vae_use_tiling=vae_use_tiling,

)

images = omni.generate(

args.prompt,

height=args.height,

width=args.width,

generator=generator,

true_cfg_scale=args.cfg_scale,

num_inference_steps=args.num_inference_steps,

num_images_per_prompt=args.num_images_per_prompt,

num_outputs_per_prompt=args.num_images_per_prompt,

)

类似xxx=LLM()的接口

TODO: 如何和设计耦合的

新模型接入¶

以QwenImage的主PR为例

文件太多了,没跑通前,太难看了。

性能实测¶

如何获得解耦流水线收益¶

profiling

参考文献¶

-

https://github.com/volcengine/verl/issues/3624 ↩

-

https://github.com/volcengine/verl/pull/3297/files ↩

-

https://docs.vllm.ai/projects/vllm-omni/en/latest/getting_started/installation/npu/ ↩

-

Announcing vLLM-Omni: Easy, Fast, and Cheap Omni-Modality Model Serving ↩↩↩

-

https://github.com/vllm-project/vllm-omni/issues/152 ↩